Strategie SEO: i Web Crawler e la loro importanza nel 2024

Un web crawler, noto anche come web spider o semplicemente crawler, è un software automatizzato che riveste un ruolo cruciale nel mondo del SEO. Il termine “crawler” è sinonimo di “Bot” o “Spider”, con Googlebot come esempio emblematico. Questi strumenti avanzati sono progettati per navigare e indicizzare i contenuti di un sito web. Sono utilizzati dai motori di ricerca come Google, Bing, Yahoo!, e altre piattaforme per esaminare e organizzare le vaste informazioni disponibili online, e ci aiuteranno a capire la loro funzione e a scoprire i più efficaci nel 2024.

Contenuto dell'articolo

Che cos’è un Web Crawler e come funziona

Come operano i web crawler? Il loro processo inizia con l’analisi del file robots.txt di un sito web. Questo file è una sorta di guida per i crawler, indicando quali pagine del sito possono essere esaminate e quali sono off-limits. Dopodiché, i crawler procedono navigando tra le pagine web, identificando nuovi URL attraverso collegamenti ipertestuali e aggiungendoli alla loro lista per future esplorazioni.

Ma qual è il segreto dietro la velocità e l’efficienza dei motori di ricerca come Google, Bing e Yahoo! nella consegna di migliaia di risultati in pochi secondi? La risposta sta nella tecnologia avanzata che essi utilizzano, e al cuore di questa tecnologia ci sono i web crawler spider. Questi crawler non sono solo strumenti di navigazione, ma il vero “cervello” dietro il funzionamento dei motori di ricerca, che permette loro di processare e organizzare enormi quantità di dati per fornire risultati rapidi e accurati agli utenti.

Le diverse tipologie di Web Crawler

La classificazione dei web crawler si suddivide in tre categorie principali: web crawler interni, web crawler commerciali, e web crawler open source. Esaminiamo brevemente queste categorie:

- Web Crawler Interni: Questi strumenti vengono sviluppati internamente dalle organizzazioni per esplorare i propri siti web. Sono impiegati per svariati scopi, come la generazione di mappe del sito e la scansione di collegamenti interrotti.

- Web Crawler Commerciali: Disponibili sul mercato per l’acquisto, questi crawler sono spesso sviluppati da aziende specializzate. Alcune importanti corporazioni possono anche utilizzare spider su misura per soddisfare specifiche esigenze di scansione del sito web.

- Web Crawler Open Source: Disponibili al pubblico con licenze gratuite o aperte, permettono agli utenti di utilizzarli e adattarli secondo le proprie esigenze. Nonostante possano mancare di alcune funzionalità avanzate presenti nei crawler commerciali, offrono l’opportunità di esplorare il codice sorgente per comprendere meglio i meccanismi del web crawling.

Esempi di Web Crawler comuni nel 2024

Nel mondo del SEO del 2024, la comprensione e l’uso efficace dei web crawler sono fondamentali. Ogni crawler possiede peculiarità e finalità specifiche, rendendoli strumenti essenziali per soddisfare le diverse esigenze di ottimizzazione. Di seguito troverai un riassunto dei crawler più comunemente utilizzati:

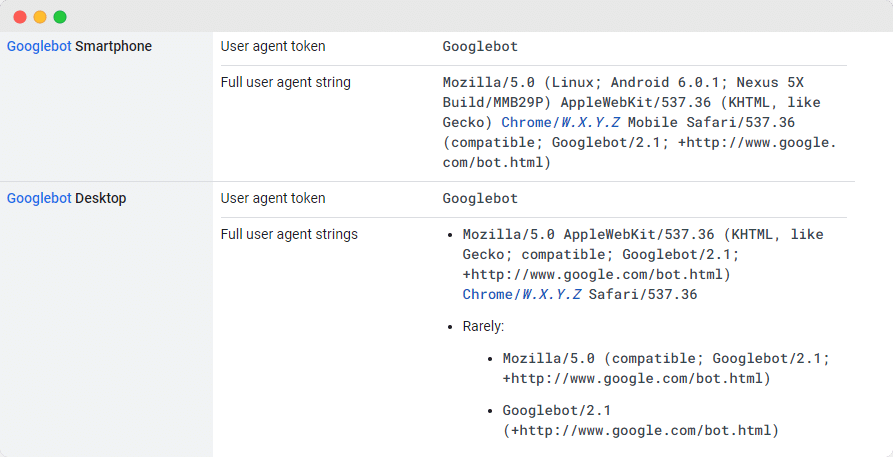

GoogleBot

Googlebot è un avanzato strumento di web crawling di Google, fondamentale per analizzare e indicizzare i siti web affinché compaiano nei risultati del motore di ricerca. Esso si articola in due varianti: una ottimizzata per i desktop e l’altra per gli smartphone, collaborando per garantire una copertura completa. La frequenza di accesso a questo crawler ai siti web è variabile, ma generalmente alta, a meno che non vi siano restrizioni nel file robots.txt. Le informazioni raccolte vengono conservate nel Google Cache, permettendo agli utenti di visualizzare versioni storiche delle pagine web. Nel 2024, la sua funzione rimane cruciale per la visibilità online e per l’elaborazione di strategie SEO efficaci.

Bingbot

Nel 2010, Microsoft ha introdotto Bingbot, uno strumento progettato per analizzare e catalogare gli URL, contribuendo a mantenere i risultati di ricerca di Bing pertinenti e aggiornati. Similmente a Googlebot, permette ai proprietari di siti web di controllare l’accesso del bot tramite il file robots.txt, decidendo se permettere o meno a Bingbot di scansionare il loro sito.

In aggiunta, Bingbot offre una particolare attenzione all’indicizzazione mobile-first e ai crawler per desktop, avendo adottato di recente un nuovo tipo di agente. Questa caratteristica, insieme all’utilizzo di Bing Webmaster Tools, fornisce ai webmaster una maggiore flessibilità nel determinare come i loro siti vengano trovati e visualizzati nei risultati di ricerca.

DuckDuck Bot

DuckDuckBot opera come crawler per DuckDuckGo, noto motore di ricerca che pone un forte accento sulla privacy dell’utente. Questo bot consente ai proprietari dei siti web di utilizzare l’API DuckDuckBot per verificare se i loro siti sono stati esaminati dal crawler.

Inoltre, nel corso delle sue attività, DuckDuckBot aggiorna continuamente il suo database API con nuovi indirizzi IP e user agent, un’azione che aiuta i webmaster a identificare eventuali impostori o bot dannosi che tentano di interagire con il sistema di DuckDuckGo. Questa funzionalità si rivela particolarmente utile per mantenere la sicurezza e l’integrità dei siti web.

Apple Bot

Apple ha sviluppato l’Apple Bot, un crawler specifico per esaminare e archiviare le pagine web in relazione ai suggerimenti forniti da Siri e Spotlight. Questo strumento è progettato per analizzare una serie di criteri al fine di stabilire quali contenuti meritino maggiormente di essere messi in evidenza nelle proposte di Siri e Spotlight.

I criteri valutati dall’Apple Bot includono l’interazione dell’utente con il sito, il significato dei termini di ricerca utilizzati, la quantità e la qualità dei collegamenti presenti sulle pagine, nonché segnali basati sulla posizione geografica e la progettazione complessiva del sito web. Questi fattori concorrono a definire la rilevanza e l’utilità delle pagine web per gli utenti che utilizzano i servizi di ricerca e assistenza vocale di Apple.

Slurp Bot

Slurp Bot, il robot di ricerca di Yahoo, gioca un ruolo fondamentale nella scansione e nell’indicizzazione delle pagine, non solo per Yahoo.com, ma anche per le sue piattaforme affiliate come Yahoo News, Yahoo Finance e Yahoo Sports. La sua funzione è essenziale per garantire che gli elenchi di siti siano pertinenti e aggiornati.

In assenza del lavoro di Slurp Bot, si avrebbe una carenza di elenchi di siti rilevanti nei risultati di ricerca di Yahoo. Il suo contributo è quindi cruciale per fornire un’esperienza web personalizzata agli utenti, caratterizzata da risultati di ricerca più pertinenti e accurati. Grazie agli sforzi di indicizzazione di Slurp Bot, gli utenti hanno accesso a contenuti più rilevanti e mirati alle loro esigenze e interessi.

Facebook External Hit

Il crawler di Facebook, noto come Facebook External Hit, svolge un ruolo importante nell’analizzare l’HTML di siti web o app condivisi su Facebook. È incaricato di creare anteprime dei collegamenti condivisi, includendo il titolo, una descrizione e un’immagine in miniatura.

La tempestività della scansione è fondamentale, poiché eventuali ritardi potrebbero impedire la corretta visualizzazione dello snippet personalizzato quando i contenuti vengono condivisi sulla piattaforma. Questo aspetto è cruciale per assicurare che le condivisioni su Facebook siano accompagnate da informazioni accurate e visivamente attraenti.

Baidu Spider

Baidu Spider, il crawler esclusivo del motore di ricerca principale in Cina, Baidu, assume un ruolo significativo per coloro che mirano a interagire con il mercato cinese. Date le specificità del panorama digitale cinese e l’assenza di Google nel paese, Baidu diventa il principale canale di ricerca online. Pertanto, se il tuo obiettivo è quello di raggiungere il pubblico cinese, è fondamentale consentire a Baidu Spider di scansionare il tuo sito web.

Per monitorare e verificare l’attività di Baidu Spider, è utile controllare gli user agent del tuo sito, come baiduspider, baiduspider-image, baiduspider-video e altri. Questo consente di capire se e come il tuo sito viene indicizzato dal motore di ricerca Baidu.

Per i siti web che non si rivolgono al mercato cinese, può essere invece opportuno bloccare Baidu Spider attraverso il file robots.txt. Questo impedisce la scansione del sito da parte del crawler di Baidu, evitando così che le pagine del sito appaiano nei risultati del motore di ricerca di Baidu (SERP), ottimizzando le risorse per i mercati di interesse specifico.

Sogou Spider

Sogou, un altro importante motore di ricerca cinese, si distingue per essere stato la prima piattaforma a indicizzare oltre 10 miliardi di pagine in lingua cinese. La conoscenza e l’utilizzo del suo crawler, Sogou Spider, sono cruciali per le aziende che operano o intendono entrare nel mercato cinese.

Sogou Spider è noto per rispettare le direttive del file robots.txt, inclusi i comandi di esclusione e le impostazioni di ritardo nella scansione, permettendo così una maggiore gestione e controllo sull’indicizzazione del proprio sito web.

Per le aziende e i siti web che non mirano al mercato cinese, potrebbe essere consigliabile disattivare Sogou Spider per prevenire rallentamenti nel caricamento del sito. Questo consente di ottimizzare le risorse web per gli utenti e i mercati di maggiore interesse, evitando l’uso non necessario di banda e risorse del server.

Swiftbot

Swiftype, un motore di ricerca personalizzato, rivoluziona la funzionalità di ricerca nei siti web grazie all’integrazione di tecnologie avanzate, algoritmi, framework per l’inserimento dei contenuti, client e strumenti analitici di alto livello. Questo strumento risulta essere particolarmente utile per i siti web che dispongono di un elevato numero di pagine, offrendo un’interfaccia intuitiva che facilita la catalogazione e l’indicizzazione efficace di tutte le pagine.

Al centro di questo processo si trova Swiftbot, il web crawler di Swiftype. Questo crawler si distingue per la sua capacità di effettuare scansioni mirate e personalizzate in base alle specifiche richieste dei clienti, differenziandosi così dagli altri bot tradizionali. Swiftbot gioca quindi un ruolo fondamentale nel garantire che il contenuto del sito sia facilmente accessibile e ben organizzato, migliorando l’esperienza di ricerca per l’utente finale.

Elenco dei migliori web crawler per padroneggiare la SEO nel 2024

Nell’approfondire il panorama dei web crawler per il 2024, diventa evidente quanto sia essenziale avere a disposizione gli strumenti giusti per mantenere il tuo sito web dinamico e ben posizionato nelle classifiche dei motori di ricerca. Questi strumenti, che spaziano dal rinomato Googlebot a soluzioni specifiche come il Swiftbot di Swiftype, sono fondamentali per l’analisi, l’indicizzazione e l’ottimizzazione del sito.

Per completare la panoramica, includiamo un ulteriore elenco di strumenti SEO essenziali:

- SEMrush: Offre un crawler avanzato per analisi dettagliate della salute tecnica del sito, dei backlink e delle classifiche delle parole chiave.

- Ahrefs: Famoso per l’analisi profonda dei backlink, delle classifiche delle parole chiave e delle prestazioni dei contenuti.

- Moz Pro: Una suite software SEO completa con un crawler che supporta la ricerca di parole chiave, l’analisi dei link e gli audit del sito.

- Screaming Frog: Un crawler SEO desktop che fornisce informazioni dettagliate sulla struttura, i contenuti e i link del tuo sito.

- DeepCrawl: Un crawler SEO basato sul cloud per un’analisi comprensiva del sito, inclusa la salute tecnica e la qualità dei contenuti.

- Sitebulb: Un crawler SEO desktop che offre analisi approfondite della salute tecnica, della qualità dei contenuti e del profilo di link.

- Ryte: Una piattaforma SEO all-in-one con un potente crawler.

- OnCrawl: Un crawler SEO basato sul cloud che fornisce analisi dettagliate della salute tecnica e della qualità dei contenuti del sito.

- Botify: Una piattaforma SEO a livello aziendale con un potente crawler.

- SEO Spider: Un crawler SEO desktop che fornisce dati sui titoli delle pagine, le descrizioni meta e i tag delle intestazioni.

L’adozione di questi strumenti nella tua strategia SEO è vitale per garantire la competitività nel continuo cambiamento del panorama digitale. Non solo facilitano il processo di ottimizzazione, ma permettono anche ai tuoi team di concentrarsi sulla creazione di contenuti di qualità, affidando ai crawler la gestione delle sfide tecniche.

In conclusione, per essere all’avanguardia nel SEO nel 2024, è cruciale integrare questi strumenti avanzati di web crawling nella tua strategia digitale. Rappresentano un investimento fondamentale nel futuro del tuo sito, assicurandosi che mantenga un’alta visibilità nei motori di ricerca. Per rimanere aggiornato sulle ultime tendenze e strumenti SEO, è consigliabile seguire blog e risorse specializzate nel settore.